哎,您有没有好奇过,现在那些自动化生产线,怎么就那么“聪明”呢?一个个零件“嗖嗖”地过,哪个有点磕碰、哪个尺寸不对,立马就被挑出来,比人眼还尖!这背后啊,多半离不开一个核心玩意儿——工业用相机。可这工业用相机是啥原理呢?咱今儿就唠点实在的,把它扒开揉碎了讲明白,保管您听完,也能说出个一二三来。

您可别把它想成您手机里那个美颜相机。它干的是硬邦邦的“体力活”兼“眼力活”。简单说吧,它的原理就像给机器装了双超级眼睛,但这双眼睛看的不是风景,而是“像素”和“数据”。它的工作流程,就跟咱人眼类似,但又死板精确得多:光线照到被检测的物体上,反射光穿过镜头,打在相机“肚子”里的一块感光芯片上(这芯片可比咱的视网膜复杂多了,不是CCD就是CMOS)。这芯片啊,就是个“光电转换器”,把光的强弱信号,“翻译”成一串串数字电信号。您猜怎么着?这翻译过程,就是工业用相机是什么原理的第一个关键——它不追求色彩多么绚烂,而是追求信号转换的稳定、快速和准确,每一个像素点的灰度值都对应着明确的物理信息,比如高度、边缘、缺陷。

那为啥有的工厂用着特顺手,有的就老闹脾气误判呢?这里头门道就深了,涉及到工业用相机是什么原理的更深一层——它不是孤胆英雄,得跟“兄弟们”配合作战。光源就是它的“最佳拍档”!光线打的角度、颜色、亮度不一样,拍出来的效果天差地别。比如看表面划痕,用低角度的条形光一打,凹槽就有阴影,立马现形;看透明的瓶盖有没有螺纹,背光一打,轮廓就清晰无比。所以啊,光懂相机本身不够,得懂怎么给它“打光”,这原理才算吃透了一半。不然您相机再好,光线没打好,拍出来一片模糊或者反光,那后端算法再厉害也白搭,这不净耽误生产进度嘛!

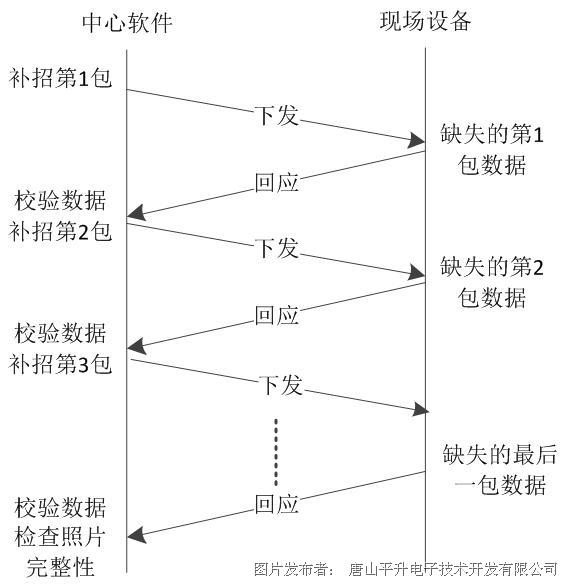

说到后端,这就引出了工业用相机是什么原理的完整闭环。图像数据采集完了,得通过千兆网、USB3.0这些高速“马路”嗖地传到工控机里。这时候,专门的图像处理软件(相当于机器的大脑皮层)就开始忙活了。它按照人预先设定的“剧本”,比如“找边缘”、“比模板”、“算面积”,去分析那些海量的像素数据。这个过程,要求相机传过来的图像“原汁原味”,不能有拖影、不能延时、不能丢包。所以工业相机的设计原理里,抗电磁干扰、长时间稳定运行、协议标准化,那都是硬指标,为的就是在车间那种震动、粉尘、温差大的“恶劣”环境里,也能几十年如一日地输出靠谱的“证据”。

说白了,工业用相机的原理,是一套从光学、机械、电子到计算机软件的协同系统。它笨吗?它一点也不笨,它只是极其忠实和高效地执行人类赋予的“看”和“判”的指令。咱们搞明白了这个,在选型和应用时才能心里有底:不是像素越高越好,得看帧率能不能跟上生产线速度;不是功能越多越好,得看接口和软件能不能跟现有系统对上号。这就像给生产线找“监工”,不是找艺术大师,得找那位最认真、最抗造、最懂标准的老师傅。

网友问题互动环节:

1. 网友“精益生产探索者”问: 老师讲得很透彻!我们正想上视觉检测设备,但对于选CCD还是CMOS芯片的工业相机很纠结,能再深入说说它们在原理和应用上的具体差别吗?该怎么选?

答: 这位朋友问到点子上了,这确实是选型的第一个坎儿。咱打个比方,CCD和CMOS就像两个性格不同的“图像记录员”。CCD这位“老同志”作风严谨,它把每个像素点感受到的光,统一排队(电荷),到芯片末尾的一个“放大器”那里集体报到(转换),所以图像干净、噪声小,一致性特别好,尤其在光线弱的时候表现稳定。早年高要求的行业,比如天文观测、高端测量,都爱用它。但它也有“老同志”的缺点:排队过程慢(帧率相对低)、耗电大、电路复杂相机容易发热。

CMOS呢,像是“年轻干将”,灵活高效。它在每个像素点边上都配了个“小秘书”(放大转换电路),光信号来了就地处理,不用排队,所以处理速度贼快(高帧率)、功耗低、集成度高(相机可以做得更小)。早些年它画质差点,噪点多,但现在技术突飞猛进,差距已经很小了。现在市面上绝大多数工业相机都是CMOS的天下了。

那怎么选?给您个心法:看需求下菜碟。如果您是做高速运动物体的分析,比如检查高速灌装线、振动中的零件,帧率是命根子,闭眼选高性能全局快门CMOS。如果您是做超高精度、微光下的静态或慢速测量,对图像均匀性、噪声要求极端苛刻,且不差钱不计较功耗,可以考虑面阵CCD。但对于95%以上的工厂视觉项目,比如尺寸测量、二维码读取、表面缺陷检测(标签、包装、装配件等),一款性能良好的工业级CMOS相机已经完全足够,性价比更高,选择也更多。记住,结合镜头的搭配和光源的优化,比单纯纠结芯片类型更重要。

2. 网友“车间小白”问: 原理懂了,但实际用起来,工业相机系统最常见的“坑”有哪些?我们怎么避免花冤枉钱?

答: 哎呀,这问题太实在了,好多企业都栽过跟头。最常见的“坑”有几个,您可记好咯:

第一坑,“唯像素论”。觉得千万像素就一定比百万像素好。结果买回来,高像素导致单张图片巨大,处理速度慢得像蜗牛,生产线都跑完了,它图还没分析完。正确思路是:先确定您要看的视野范围和精度(比如看一个10mm的零件,要测到0.01mm的精度),反推出需要的像素。帧率(每秒拍多少张)和传输速度,往往比单纯的高像素关键得多。

第二坑,“忽视光源”。舍得花几万买相机,却只配个几十块的普通LED灯。光线不稳、角度不对,再贵的相机也抓瞎。正确做法是:把光源当成核心部件来预算和选型。做demo测试时,一定要用候选的光源和相机一起试,好的光源能让复杂的图像处理算法简单化。

第三坑,“软件和集成”想得太简单。以为买了相机就能直接用。实际上,图像处理软件的授权费、开发调试的人工成本、以及与PLC或机器人通讯集成的难度,往往比硬件本身还烧钱耗时。避坑指南:要么找提供完整解决方案(包括软件和集成服务)的靠谱供应商;要么自己团队要有懂视觉编程(如Halcon, VisionPro, OpenCV)和自动化通讯的人才。前期充分的POC(概念验证)测试,用实际工件在模拟环境下跑通,是避免后期“掉坑”的最佳保险。

3. 网友“技术前瞻者”问: 现在AI和深度学习这么火,它和传统的工业相机视觉原理是冲突的吗?未来会不会彻底取代传统算法?

答: 这位朋友眼光很前瞻!这绝对不是冲突,而是一次美妙的“强强联合”和原理升级。传统机器视觉原理,是基于规则的、确定性的。我们告诉它“边缘在哪里算合格”、“灰度值超过多少算瑕疵”,它严格执行,对于特征明确、环境稳定的检测,效率极高。

而AI深度学习,特别是卷积神经网络,它的原理更像是“经验学习”。我们给它看海量的合格品和不合格品图片(打上标签),它自己从海量像素中总结、抽象出那些我们人类可能都难以描述的“特征”,自己形成一套判别的“感觉”。这对于传统算法头疼的、特征模糊的复杂缺陷(比如皮革的天然纹理 vs 划伤、焊接泡的细微差别)、多变的背景,有奇效。

所以,未来不是“取代”,而是“融合”与“分工”。未来工业视觉系统的原理,会是“传统规则算法” + “AI深度学习”的双核大脑。简单、规则明确、要求高速的检测,用传统算法,稳定可靠。复杂、难以描述、新品迭代快的检测,用AI模型,灵活聪明。现在很多高端工业相机已经内置了AI芯片,可以在前端就完成一些简单的智能判断,这就是“边缘计算”在视觉里的应用。您可以理解为,相机的“眼睛”里,开始自带一点“大脑”了。对于企业来说,不需要恐慌,可以逐步在那些传统方法“啃不动”的复杂工位上,尝试引入AI视觉方案,积累数据和经验,这一定是未来提升自动化和智能化水平的关键路径。